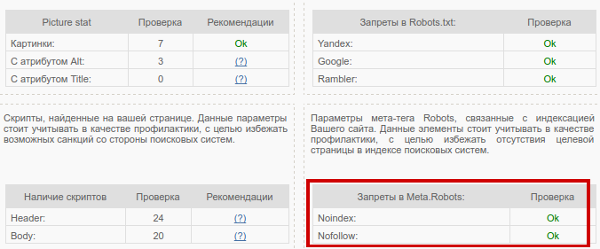

Nofollow meta: Meta Robots Tag [noindex, nofollow]

HTML МЕТА-тег ROBOTS

У Вас в браузере заблокирован JavaScript. Разрешите JavaScript для работы сайта!

МЕТА тег robots служит для того, чтобы разрешать или запрещать роботам, приходящим на сайт, индексировать данную страницу. Кроме того, этот тег предназначен для того, чтобы предлагать роботам пройтись по всем страницам сайта и проиндексировать их. Кроме того, этим тегом могут воспользоваться те, кто не имеет доступа к корневому каталогу сервера и изменить файл robots.txt, но хочет запретить к индексированию свои файлы и директории.

Формат мета-тега Robots

МЕТА тег robots помещается в тег html-документа (внутри тега <HEAD>).

Формат достаточно прост (регистр букв значения не играет)

<META NAME=»ROBOTS» CONTENT=»value»>

Данному мета-тегу можно присвоить варианта четыре значений. Атрибут CONTENT может содержать следующие значения:

Index (индексировать), noindex (не индексировать), follow (следовать по ссылкам),

Например, не индексировать данный документ:

<META NAME="ROBOTS" CONTENT="NOINDEX>

Робот поисковой машины не должен идти по ссылкам с данной страницы.

<META NAME="ROBOTS" CONTENT="NOFOLLOW">

Для одновременного запрета индексирования страницы и обхода ссылок с нее используйте

<META NAME="ROBOTS" CONTENT="NOINDEX,NOFOLLOW">Если значений несколько, то они разделяются запятыми.

Чтобы запретить индексирование страницы на вашем сайте только роботам Google и разрешить ее индексирование другим роботам, используйте следующий тег:

<META NAME="GOOGLEBOT" CONTENT="NOINDEX, NOFOLLOW">Чтобы разрешить роботам индексировать страницу, но запретить индексирование картинок на странице, используйте следующий тег:

<META NAME="ROBOTS" CONTENT="NOIMAGEINDEX">

Google автоматически создает и архивирует «снимок» каждой сканируемой страницы. Версия, сохраненная в кэше, позволяет показывать вашу страницу конечным пользователям, даже если исходная страница недоступна (из-за временной технической проблемы на веб-сервере). Сохраненная в кэше страница представляется пользователям в том виде, в котором ее в последний раз просканировал робот Google, при этом вверху страницы мы показываем сообщение о том, что это версия из кэша. Пользователи могут получить доступ к кэшированной версии, нажав на ссылку «Сохранено в кэше», расположенную на странице результатов поиска.

Чтобы запретить всем поисковым системам выводить эту ссылку на ваш сайт, добавьте в раздел <HEAD> следующий тег:

<META NAME="ROBOTS" CONTENT="NOARCHIVE">Чтобы запретить выводить ссылку «Сохранено в кэше» только системе Google, а остальным разрешить, используйте следующий тег:

<META NAME="GOOGLEBOT" CONTENT="NOARCHIVE">Примечание. Этот тег удаляет только ссылку «Сохранено в кэше» на соответствующую страницу. Google продолжит индексировать страницу и выводить ее фрагмент.

Предотвращение сканирования или удаление фрагментов

Фрагмент — это текст, который показывается под названием страницы в списке результатов поиска и описывает содержание страницы.

Чтобы запретить Google выводить фрагменты с вашей страницы, добавьте в раздел <HEAD> следующий тег:

<META NAME="GOOGLEBOT" CONTENT="NOSNIPPET">Примечание. При удалении фрагментов удаляются также и сохраненные в кэше страницы.

Как сделать так, чтобы поисковые системы не использовали данные DMOZ в результатах поиска для вашего сайта

Одним из источников, которые используются при создании фрагментов описаний, является Open Directory Project. Чтобы никакие поисковые системы (поддерживающие метатеги) не использовали эту информацию для описания страницы, добавьте следующий тег:

<META NAME="ROBOTS" CONTENT="NOODP">

Чтобы только для Google запретить использовать эту информацию в описании страницы, добавьте тег:

<META NAME="GOOGLEBOT" CONTENT="NOODP">

Если метатег «robots» используется для других команд, их можно объединить. Пример:

<META NAME="GOOGLEBOT" CONTENT="NOODP, NOFOLLOW">

Пример использования описания:

<META NAME="Description" CONTENT="Информация для WEB-разработчиков, программистов и студентов ВУЗ-ов, изучающх WEB-технологии.">

Поисковые запреты

Как сказать поисковой машине, что определенный участок кода не нужно индесировать или что по определенной ссылке не нужно следовать?

Каждый поисковик тут изобретает свой велосипед: Yandex рекомендует заключать подобный текст в теги <noindex>,

Тег NOINDEX

Запретить индексирование можно не только для файлов, но также и для их частей. Для того, чтобы запретить индексирование определенных частей файлов (текстовых), необходимо пометить их специальными тегами .При этом, тег NOINDEX не должен нарушать вложенность других тегов. Понимает только ПС Яндекс.

rel=»nofollow»

Чтобы указать поисковой системе не идти по ссылке, в теге A можно задать атрибут rel=»nofollow»:

<a rel="nofollow" href="htmlweb.ru>WEB-технологии</a>Данный атрибут не влияет на индексацию ссылки. В большинстве поисковиков (кроме Google) переход по ней все-таки осуществляется. Единственная задача данного атрибута — сообщить поисковой системе, что рейтинг со страницы, на которой ссылка размещена, не должен передаваться странице, на которую данная ссылка ведет.

Использованны материалы с сайтов поисковых систем:

Google

class=»robots-nocontent»

Применение «class=robots-nocontent» атрибут:Ниже приводятся несколько примеров того, как применять этот атрибут для различных целей и различных вариантов синтаксиса:

<div> Это навигационного меню сайта и является общим на всех страницах. Она содержит много терминов и слов, не связанных с сайтом </div>

<span>

Это сайт заголовок, который присутствует на всех страницах сайта

и не связан с какой-либо конкретной страницей

</span><p>

Это Юридическая информация требуется на каждую страницу сайта

</p>Как часто индексировать документ поисковому роботу?

Вебмастер может «сказать» поисковому роботу или файлу bookmark пользователя, что содержимое того или иного файла будет изменяться. В этом случае робот не будет сохранять URL, а браузер пользователя внесет или не внесет это файл в bookmark. Пока эта информация описывается только в файле /robots.txt, Пользователь не будет знать о том, что эта страница будет изменяться.

Мета-таг DOCUMENT-STATE может быть полезен для этого. По умолчанию, этот мета-таг принимается с CONTENT=STATIC.

<META NAME="DOCUMENT-STATE" CONTENT="STATIC">

<META NAME="DOCUMENT-STATE" CONTENT="DYNAMIC">Зеркала

Как исключить индексирование поисковой системой генерируемых страниц или дублирование документов, если есть зеркала сервера?

Генерируемые страницы — страницы, порождаемые действием CGI-скриптов. Их наверняка не следует индексировать, поскольку если попробовать провалиться в них из поисковой системы, будет выдана ошибка. Что касается зеркал, то негоже, когда выдаются две разные ссылки на разные сервера, но с одним и тем же содержимым. Чтобы этого избежать, следует использовать мета-таг

<META NAME="URL" CONTENT="absolute_url">Ещё почитать по теме:

Полное руководство по Robots.txt и метатегу Noindex

Файл Robots.txt и мета-тег Noindex важны для SEO-продвижения. Они информируют Google, какие именно страницы необходимо сканировать, а какие – индексировать (отображать в результатах поиска).

С помощью этих средств можно ограничить содержимое сайта, доступное для индексации.

Robots.txt – это файл, который указывает поисковым роботам (например, Googlebot и Bingbot), какие страницы сайта не должны сканироваться.

Файл robots.txt сообщает роботам системам, какие страницы могут быть просканированы. Но не может контролировать их поведение и скорость сканирования сайта. Этот файл, по сути, представляет собой набор инструкций для поисковых роботов о том, к каким частям сайта доступ ограничен.

Но не все поисковые системы выполняют директивы файла robots.txt. Если у вас остались вопросы насчет robots.txt, ознакомьтесь с часто задаваемыми вопросами о роботах.

По умолчанию файл robots.txt выглядит следующим образом:

Можно создать свой собственный файл robots.txt в любом редакторе, который поддерживает формат .txt. С его помощью можно заблокировать второстепенные веб-страницы сайта. Файл robots.txt – это способ сэкономить лимиты, которые могут пойти на сканирование других разделов сайта.

User-Agent: определяет поискового робота, для которого будут применяться ограничения в сканировании URL-адресов. Например, Googlebot, Bingbot, Ask, Yahoo.

Disallow: определяет адреса страниц, которые запрещены для сканирования.

Allow: только Googlebot придерживается этой директивы. Она разрешает анализировать страницу, несмотря на то, что сканирование родительской веб-страницы запрещено.

Sitemap: указывает путь к файлу sitemap сайта.

В файле robots.txt символ (*) используется для обозначения любой последовательности символов.

Директива для всех типов поисковых роботов:

User-agent:*

Также символ * можно использовать, чтобы запретить все URL-адреса кроме родительской страницы.

User-agent:*

Disallow: /authors/*

Disallow: /categories/*

Это означает, что все URL-адреса дочерних страниц авторов и страниц категорий заблокированы за исключением главных страниц этих разделов.

Ниже приведен пример правильного файла robots.txt:

User-agent:* Disallow: /testing-page/ Disallow: /account/ Disallow: /checkout/ Disallow: /cart/ Disallow: /products/page/* Disallow: /wp/wp-admin/ Allow: /wp/wp-admin/admin-ajax.php Sitemap: yourdomainhere.com/sitemap.xml

После того, как отредактируете файл robots.txt, разместите его в корневой директории сайта. Благодаря этому поисковый робот увидит файл robots.txt сразу после захода на сайт.

Noindex – это метатег, который запрещает поисковым системам индексировать страницу.

Существует три способа добавления Noindex на страницы:

Разместите приведенный ниже код в раздел <head> страницы:

<meta name=”robots” content=”noindex”>

Он сообщает всем типам поисковых роботов об условиях индексации страницы. Если нужно запретить индексацию страницы только для определенного робота, поместите его название в значение атрибута name.

Чтобы запретить индексацию страницы для Googlebot:

<meta name=”googlebot” content=”noindex”>

Чтобы запретить индексацию страницы для Bingbot:

<meta name=”bingbot” content=”noindex”>

Также можно разрешить или запретить роботам переход по ссылкам, размещенным на странице.

Чтобы разрешить переход по ссылкам на странице:

<meta name=”robots” content=”noindex,follow”>

Чтобы запретить поисковым роботам сканировать ссылки на странице:

<meta name=”robots” content=”noindex,nofollow”>

x-robots-tag позволяет управлять индексацией страницы через HTTP-заголовок. Этот тег также указывает поисковым системам не отображать определенные типы файлов в результатах поиска. Например, изображения и другие медиа-файлы.

Для этого у вас должен быть доступ к файлу .htaccess. Директивы в метатеге «robots» также применимы к x-robots-tag.

Плагин YoastSEO в WordPress автоматически генерирует приведенный выше код. Для этого на странице записи перейдите в интерфейсе YoastSEO в настройки публикации, щелкнув по значку шестеренки. Затем в опции «Разрешить поисковым системам показывать эту публикацию в результатах поиска?» выберите «Нет».

Также можно задать тег noindex для страниц категорий. Для этого зайдите в плагин Yoast, в «Вид поиска». Если в разделе «Показать категории в результатах поиска» выбрать «Нет», тег noindex будет размещен на всех страницах категорий.

- Чтобы проиндексированная страница была удалена из результатов поиска, убедитесь, что она не заблокирована в файле robots.txt. И только потом добавляйте тег noindex. Иначе Googlebot не сможет увидеть тег на странице. Если заблокировать страницу без тега noindex, она все равно будет отображаться в результатах поиска:

- Добавление директивы sitemap в файл robots.txt технически не требуется, но считается хорошей практикой.

- После обновления файла robots.txt рекомендуется проверить, не заблокированы ли важные страницы. Это можно сделать с помощью txt Tester в Google Search Console.

- Используйте инструмент проверки URL-адреса в Google Search Console, чтобы увидеть статус индексации страницы.

- Также можно проверить, проиндексировал ли Google ненужные страницы. Это можно сделать с помощью отчета в Google Search Console. Еще одной альтернативой может быть использование оператора «site». Это команда Google, которая отображает все страницы сайта, доступные в результатах поиска.

В последнее время в SEO-сообществе было много недоразумений по поводу использования noindex в robots.txt. Но представители Google много раз говорили, что поисковая система не поддерживают данный метатег. И все же многие люди настаивают на том, что он все еще работает. Но лучше избегать его использования.

Заблокированные через robots.txt страницы, не могут быть проиндексированы, даже если кто-то на них ссылается.

Чтобы быть уверенным, что страница без контента случайно не появится в результатах поиска, Джон Мюллер рекомендует размещать на этих веб-страницах noindex даже после того, как вы заблокировали их в robots.txt.

Использование файла robots.txt улучшает не только SEO, но и пользовательский опыт. Для этого реализуйте приведенные выше практики.

Данная публикация представляет собой перевод статьи «The Complete Guide to Robots.txt and Noindex Meta Tag» , подготовленной дружной командой проекта Интернет-технологии.ру

телеграм канал. Подпишись, будет полезно!

Руководство по метатегам Robots и X-robots-tag

Перед вами дополненный (конечно же, выполненный с любовью) перевод статьи Robots Meta Tag & X-Robots-Tag: Everything You Need to Know c блога Ahrefs. Дополненный, потому что в оригинальном материале «Яндекс» упоминается лишь вскользь, а в главе про HTTP-заголовки затрагивается только сервер Apache. Мы дополнили текст информацией по метатегам «Яндекса», а в части про X-Robots-Tag привели примеры для сервера Nginx. Так что этот перевод актуален для наиболее популярных для России поисковых систем и веб-серверов. Круто, правда?

Приятного чтения!

Направить поисковые системы таким образом, чтобы они сканировали и индексировали ваш сайт именно так, как вы того хотите, порой может быть непросто. Хоть robots.txt и управляет доступностью вашего контента для ботов поисковых систем, он не указывает краулерам на то, стоит индексировать страницы или нет.

Для этой цели существуют метатеги robots и HTTP-заголовок X-Robots-Tag.

Давайте проясним одну вещь с самого начала: вы не можете управлять индексацией через robots.txt. Распространенное заблуждение — считать иначе.

Правило noindex в robots.txt официально никогда не поддерживалось Google. 2 июля 2019 года Google опубликовал новость, в которой описал нерелевантные и неподдерживаемые директивы файла robots.txt. С 1 сентября 2019 года такие правила, как noindex в robots.txt, официально не поддерживаются.

Из этого руководства вы узнаете:

- что такое метатег robots;

- почему robots важен для поисковой оптимизации;

- каковы значения и атрибуты метатега robots;

- как внедрить robots;

- что такое X-Robots-Tag;

- как внедрить X-Robots-Tag;

- когда нужно использовать метатег robots, а когда — X-Robots-Tag;

- как избежать ошибок индексации и деиндексации.

Что такое метатег robots

Это фрагмент HTML-кода, который указывает поисковым системам, как сканировать и индексировать определенную страницу. Robots помещают в контейнер <head> кода веб-страницы, и выглядит это следующим образом:

<meta name="robots" content="noindex" />

Почему метатег robots важен для SEO

Метатег robots обычно используется для того, чтобы предотвратить появление страниц в выдаче поисковых систем. Хотя у него есть и другие возможности применения, но об этом позже.

Есть несколько типов контента, который вы, вероятно, хотели бы закрыть от индексации поисковыми системами. В первую очередь это:

- страницы, ценность которых крайне мала для пользователей или отсутствует вовсе;

- страницы на стадии разработки;

- страницы администратора или из серии «спасибо за покупку!»;

- внутренние поисковые результаты;

- лендинги для PPC;

- страницы с информацией о грядущих распродажах, конкурсах или запуске нового продукта;

- дублированный контент. Не забывайте настраивать тег canonical для того, чтобы предоставить поисковым системам наилучшую версию для индексации.

В общем, чем больше ваш веб-сайт, тем больше вам придется поработать над управлением краулинговой доступностью и индексацией. Еще вы наверняка хотели бы, чтобы Google и другие поисковые системы сканировали и индексировали ваш сайт с максимально возможной эффективностью. Да? Для этого нужно правильно комбинировать директивы со страницы, robots.txt и sitemap.

Какие значения и атрибуты есть у метатега robots

Метатег robots содержит два атрибута: name и content.

Следует указывать значения для каждого из этих атрибутов. Их нельзя оставлять пустыми. Давайте разберемся, что к чему.

Атрибут name и значения user-agent

Атрибут name уточняет, для какого именно бота-краулера предназначены следующие после него инструкции. Это значение также известно как user-agent (UA), или «агент пользователя». Ваш UA отражает то, какой браузер вы используете для просмотра страницы, но вот у Google UA будет, например, Googlebot или Googlebot-image.

Значения user-agent, robots, относится только к ботам поисковых систем. Цитата из официального руководства Google:

Тег

<meta name="robots" content="noindex" />и соответствующая директива применяются только к роботам поисковых систем. Чтобы заблокировать доступ другим поисковым роботам, включая AdsBot-Google, возможно, потребуется добавить отдельные директивы для каждого из них, например<meta name="AdsBot-Google" content="noindex" />.

Вы можете добавить столько метатегов для различных роботов, сколько вам нужно. Например, если вы не хотите, чтобы картинки с вашего сайта появлялись в поисковой выдаче Google и Bing, то добавьте в шапку следующие метатеги:

<meta name="googlebot-image" content="noindex" /><meta name="MSNBot-Media" content="noindex" />

Примечание: оба атрибута — name и content — нечувствительны к регистру. То есть абсолютно не важно, напишите ли вы их с большой буквы или вообще ЗаБоРчИкОм.

Атрибут content и директивы сканирования и индексирования

Атрибут content содержит инструкции по поводу того, как следует сканировать и индексировать контент вашей страницы. Если никакие метатеги не указаны или указаны с ошибками, и бот их не распознал, то краулеры расценят гнетущую тишину их отсутствия как «да», т. е. index и follow. В таком случае страница будет проиндексирована и попадет в поисковую выдачу, а все исходящие ссылки будут учтены. Если только ссылки непосредственно не завернуты в тег rel=»nofollow» .

Ниже приведены поддерживаемые значения атрибута content.

all

Значение по умолчанию для index, follow. Вы спросите: зачем оно вообще нужно, если без этой директивы будет равным образом то же самое? И будете чертовски правы. Нет абсолютно никакого смысла ее использовать. Вообще.

<meta name="robots" content="all" />

noindex

Указывает ПС на то, что данную страницу индексировать не нужно. Соответственно, в SERP она не попадет.

<meta name="robots" content="noindex" />

nofollow

Краулеры не будут переходить по ссылкам на странице, но следует заметить, что URL страниц все равно могут быть просканированы и проиндексированы, в особенности если на них ведут внешние ссылки.

<meta name="robots" content="nofollow" />

none

Комбинация noindex и nofollow как кофе «два в одном». Google и Yandex поддерживают данную директиву, а вот, например, Bing — нет.

<meta name="robots" content="none" />

noarchive

Предотвращает показ кешированной версии страницы в поисковой выдаче.

<meta name="robots" content="noarchive" />

notranslate

Говорит Google о том, что ему не следует предлагать перевод страницы в SERP. «Яндексом» не поддерживается.

<meta name="robots" content="notranslate" />

noimageindex

Запрещает Google индексировать картинки на странице. «Яндексом» не поддерживается.

<meta name="robots" content="noimageindex" />

Указывает Google на то, что страницу нужно исключить из поисковой выдачи после указанной даты или времени. В целом это отложенная директива noindex с таймером. Бомба деиндексации с часовым механизмом, если изволите. Дата и время должны быть указаны в формате RFC 850. Если время и дата указаны не будут, то директива будет проигнорирована. «Яндекс» ее тоже не знает.

<meta name="robots" content="unavailable_after: Sunday, 01-Sep-19 12:34:56 GMT" />

nosnippet

Отключает все текстовые и видеосниппеты в SERP. Кроме того, работает и как директива noarchive. «Яндексом» не поддерживается.

<meta name="robots" content="nosnippet" />

Важное примечание

С октября 2019 года Google предлагает более гибкие варианты управления отображением сниппетов в поисковой выдаче. Сделано это в рамках модернизации авторского права в Евросоюзе. Франция стала первой страной, которая приняла новые законы вместе со своим обновленным законом об авторском праве.

Новое законодательство хоть и введено только в Евросоюзе, но затрагивает владельцев сайтов повсеместно. Почему? Потому что Google больше не показывает сниппеты вашего сайта во Франции (пока только там), если вы не внедрили на страницы новые robots-метатеги.

Мы описали каждый из нововведенных тегов ниже. Но вкратце: если вы ищете быстрое решение для исправления сложившейся ситуации, то просто добавьте следующий фрагмент HTML-кода на каждую страницу сайта. Код укажет Google на то, что вы не хотите никаких ограничений по отображению сниппетов. Поговорим об этом более подробно далее, а пока вот:

<meta name="robots" content=”max-snippet:-1, max-image-preview:large, max-video-preview:-1" />

Заметьте, что если вы используете Yoast SEO, этот фрагмент кода уже добавлен на все ваши страницы, при условии, что они не отмечены директивами noindex или nosnippet.

Нижеуказанные директивы не поддерживаются ПС «Яндекс».

max-snippet

Уточняет, какое максимальное количество символов Google следует показывать в своих текстовых сниппетах. Значение «0» отключит отображение текстовых сниппетов, а значение «-1» укажет на то, что верхней границы нет.

Вот пример тега, указывающего предел в 160 символов (стандартная длина meta description):

<meta name="robots" content="max-snippet:160" />

max-image-preview

Сообщает Google, какого размера картинку он может использовать при отображении сниппета и может ли вообще. Есть три опции:

- none — картинки в сниппете не будет вовсе;

- standart — в сниппете появится (если появится) картинка обыкновенного размера;

- large — может быть показана картинка максимального разрешения из тех, что могут влезть в сниппет.

<meta name="robots" content="max-image-preview:large" />

max-video-preview

Устанавливает максимальную продолжительность видеосниппета в секундах. Аналогично текстовому сниппету значение «0» выключит опцию показа видео, значение «-1» укажет, что верхней границы по продолжительности видео не существует.

Например, вот этот тег скажет Google, что максимально возможная продолжительность видео в сниппете — 15 секунд:

<meta name="robots" content="max-video-preview:15" />

noyaca

Запрещает «Яндексу» формировать автоматическое описание с использованием данных, взятых из «Яндекс.Каталога». Для Google не поддерживается.

Примечание относительно использования HTML-атрибута data-nosnippet

Вместе с новыми директивами по метатегу robots, представленными в октябре 2019 года, Google также ввел новый HTML-атрибут data-nosnippet. Атрибут можно использовать для того, чтобы «заворачивать» в него фрагменты текста, который вы не хотели бы видеть в качестве сниппета.

Новый атрибут может быть применен для элементов <div>, <span> и <section>. Data-nosnippet — логический атрибут, то есть он корректно функционирует со значениями или без них.

Вот два примера:

<p>Фрагмент этого текста может быть показан в сниппете <span data-nosnippet>за исключением этой части.</span></p><div data-nosnippet>Этот текст не появится в сниппете.</div><div data-nosnippet="true">И этот тоже.</div>

Использование вышеуказанных директив

В большинстве случаев при поисковой оптимизации редко возникает необходимость выходить за рамки использования директив noindex и nofollow, но нелишним будет знать, что есть и другие опции.

Вот таблица для сравнения поддержки различными ПС упомянутых ранее директив.

| Директива | «Яндекс» | Bing | |

|---|---|---|---|

| all | ✅ | ✅ | ❌ |

| noindex | ✅ | ✅ | ✅ |

| nofollow | ✅ | ✅ | ✅ |

| none | ✅ | ✅ | ❌ |

| noarchive | ✅ | ✅ | ✅ |

| nosnippet | ✅ | ❌ | ✅ |

| max-snippet | ✅ | ❌ | ❌ |

| max-snippet-preview | ✅ | ❌ | ❌ |

| max-video-preview | ✅ | ❌ | ❌ |

| notranslate | ✅ | ❌ | ❌ |

| noimageindex | ✅ | ❌ | ❌ |

| unavailable_after: | ✅ | ❌ | ❌ |

| noyaca | ❌ | ✅ | ❌ |

| index|follow|archive | ✅ | ✅ | ✅ |

Вы можете сочетать различные директивы.

И вот здесь очень внимательно

Если директивы конфликтуют друг с другом (например, noindex и index), то Google отдаст приоритет запрещающей, а «Яндекс» — разрешающей директиве. То есть боты Google истолкуют такой конфликт директив в пользу noindex, а боты «Яндекса» — в пользу index.

Примечание: директивы, касающиеся сниппетов, могут быть переопределены в пользу структурированных данных, позволяющих Google использовать любую информацию в аннотации микроразметки. Если вы хотите, чтобы Google не показывал сниппеты, то измените аннотацию соответствующим образом и убедитесь, что у вас нет никаких лицензионных соглашений с ПС, таких как Google News Publisher Agreement, по которому поисковая система может вытягивать контент с ваших страниц.

Как настроить метатеги robots

Теперь, когда мы разобрались, как выглядят и что делают все директивы этого метатега, настало время приступить к их внедрению на ваш сайт.

Как уже упоминалось выше, метатегам robots самое место в head-секции кода страницы. Все, в принципе, понятно, если вы редактируете код вашего сайта через разные HTML-редакторы или даже блокнот. Но что делать, если вы используете CMS (Content Management System, в пер. — «система управления контентом») со всякими SEO-плагинами? Давайте остановимся на самом популярном из них.

Внедрение метатегов в WordPress с использованием плагина Yoast SEO

Тут все просто: переходите в раздел Advanced и настраивайте метатеги robots в соответствии с вашими потребностями. Вот такие настройки, к примеру, внедрят на вашу страницу директивы noindex, nofollow:

Строка meta robots advanced дает вам возможность внедрять отличные от noindex и nofollow директивы, такие как max-snippet, noimageindex и так далее.

Еще один вариант — применить нужные директивы сразу по всему сайту: открывайте Yoast, переходите в раздел Search Appearance. Там вы можете указать нужные вам метатеги robots на все страницы или на выборочные, на архивы и структуры сайта.

Примечание: Yoast — вовсе не единственный способ управления вашим метатегами в CMS WordPress. Есть альтернативные SEO-плагины со сходным функционалом.

Что такое X-Robots-Tag

Метатеги robots замечательно подходят для того, чтобы закрывать ваши HTML-страницы от индексирования, но что делать, если, например, вы хотите закрыть от индексирования файлы типа изображений или PDF-документов? Здесь в игру вступает X-Robots-Tag.

X-Robots-Tag — HTTP-заголовок, но, в отличие от метатега robots, он находится не на странице, а непосредственно в файле конфигурации сервера. Это позволяет ему сообщать ботам поисковых систем инструкции по индексации страницы даже без загрузки содержимого самой страницы. Потенциальная польза состоит в экономии краулингового бюджета, так как боты ПС будут тратить меньше времени на интерпретацию ответа страницы, если она, например, будет закрыта от индексации на уровне ответа веб-сервера.

Вот как выглядит X-Robots-Tag:

Чтобы проверить HTTP-заголовок страницы, нужно приложить чуть больше усилий, чем требуется на проверку метатега robots. Например, можно воспользоваться «дедовским» методом и проверить через Developer Tools или же установить расширение на браузер по типу Live HTTP Headers.

Последнее расширение мониторит весь HTTP-трафик, который ваш браузер отправляет (запрашивает) и получает (принимает ответы веб-серверов). Live HTTP Headers работает, так сказать, в прямом эфире, так что его нужно включать до захода на интересующий сайт, а уже потом смотреть составленные логи. Выглядит все это следующим образом:

Как правильно внедрить X-Robots-Tag

Конфигурация установки в целом зависит от типа используемого вами сервера и того, какие страницы вы хотите закрыть от индексирования.

Строчка искомого кода для веб-сервера Apache будет выглядеть так:

Header set X-Robots-Tag «noindex»Для nginx — так:

add_header X-Robots-Tag «noindex, noarchive, nosnippet»;Наиболее практичным способом управления HTTP-заголовками будет их добавление в главный конфигурационный файл сервера. Для Apache обычно это httpd.conf или файлы .htaccess (именно там, кстати, лежат все ваши редиректы). Для nginx это будет или nginx.conf, где лежат общие конфигурации всего сервера, или файлы конфигурации отдельных сайтов, которые, как правило, находятся по адресу etc/nginx/sites-available.

X-Robots-Tag оперирует теми же директивами и значениями атрибутов, что и метатег robots. Это из хороших новостей. Из тех, что не очень: даже малюсенькая ошибочка в синтаксисе может положить ваш сайт, причем целиком. Так что два совета:

- при каких-либо сомнениях в собственных силах, лучше доверьте внедрение X-Robots-Tag тем, кто уже имеет подобный опыт;

- не забывайте про бекапы — они ваши лучшие друзья.

Подсказка: если вы используете CDN (Content Delivery Network), поддерживающий бессерверную архитектуру приложений для Edge SEO, вы можете изменить как метатеги роботов, так и X-Robots-теги на пограничном сервере, не внося изменений в кодовую базу.

Когда использовать метатеги robots, а когда — X-Robots-tag

Да, внедрение метатегов robots хоть и выглядит более простым и понятным, но зачастую их применение ограничено. Рассмотрим три примера.

Файлы, отличные от HTML

Ситуация: нужно впихнуть невпихуемое.

Фишка в том, что у вас не получится внедрить фрагмент HTML-кода в изображения или, например, в PDF-документы. В таком случае X-Robots-Tag — безальтернативное решение.

Вот такой фрагмент кода задаст HTTP-заголовок со значением noindex для всех PDF-документов на сайте для сервера Apache:

Header set X-Robots-Tag «noindex»А такой — для nginx:

location ~* \.pdf$ { add_header X-Robots-Tag «noindex»; }Масштабирование директив

Если есть необходимость закрыть от индексации целый домен (поддомен), директорию (поддиректорию), страницы с определенными параметрами или что-то другое, что требует массового редактирования, ответ будет один: используйте X-Robots-Tag. Можно, конечно, и через метатеги, но так будет проще. Правда.

Изменения заголовка HTTP можно сопоставить с URL-адресами и именами файлов с помощью различных регулярных выражений. Массовое редактирование в HTML с использованием функции поиска и замены, как правило, требует больше времени и вычислительных мощностей.

Трафик с поисковых систем, отличных от Google

Google поддерживает оба способа — и robots, и X-Robots-Tag. «Яндекс» хоть и с отставанием, но в конце концов научился понимать X-Robots-Tag и успешно его поддерживает. Но, например, чешский поисковик Seznam поддерживает только метатеги robots, так что пытаться закрыть сканирование и индексирование через HTTP-заголовок не стоит. Поисковик просто не поймет вас. Придется работать с HTML-версткой.

Как избежать ошибок доступности краулинга и деиндексирования страниц

Вам, естественно, нужно показать пользователям все ваши страницы с полезным контентом, избежать дублированного контента, всевозможных проблем и не допустить попадания определенных страниц в индекс. А если у вас немаленький сайт с тысячами страниц, то приходится переживать еще и за краулинговый бюджет. Это вообще отдельный разговор.

Давайте пробежимся по распространенным ошибкам, которые допускают люди в отношении директив для роботов.

Ошибка 1. Внедрение noindex-директив для страниц, закрытых через robots.txt

Официальные инструкции основных поисковых систем гласят:

«Яндекс»GoogleНикогда не закрывайте через disallow в robots.txt те страницы, которые вы пытаетесь удалить из индекса. Краулеры поисковых систем просто не будут переобходить такие страницы и, следовательно, не увидят изменения в noindex-директивах.

Если вас не покидает чувство, что вы уже совершили подобную ошибку в прошлом, то не помешает выяснить истину через Ahrefs Site Audit. Смотрите на страницы, отмеченные ошибкой noindex page receives organic traffic («закрытые от индексации страницы, на которые идет органический трафик»).

Если на ваши страницы с директивой noindex идет органический трафик, то очевидно, что они все еще в индексе, и вполне вероятно, что робот их не просканировал из-за запрета в robots.txt. Проверьте и исправьте, если это так.

Ошибка 2. Плохие навыки работы с sitemap.xml

Если вы пытаетесь удалить контент из индекса, используя метатеги robots или X-Robots-Tag, то не стоит удалять их из вашей карты сайта до момента их деиндексации. В противном случае переобход этих страниц может занять у Google больше времени.

— …ускоряет ли процесс деиндексации отправка Sitemap.xml с URL, отмеченным как noindex?

— В принципе все, что вы внесете в sitemap.xml, будет рассмотрено быстрее.

Для того чтобы потенциально ускорить деиндексацию ваших страниц, установите дату последнего изменения вашей карты сайта на дату добавления тега noindex. Это спровоцирует переобход и переиндексацию.

Еще один трюк, который вы можете проделать, — загрузить sitemap.xml с датой последней модификации, совпадающей с датой, когда вы отметили страницу 404, чтобы вызвать переобход.

Джон Мюллер говорит здесь про страницы с ошибкой 404, но можно полагать, что это высказывание справедливо и для директив noindex.

Важное замечание

Не оставляйте страницы, отмеченные директивой noindex, в карте сайта на долгое время. Как только они выпадут из индекса, удаляйте их.

Если вы переживаете, что старый, успешно деиндексированный контент по каким-то причинам все еще может быть в индексе, проверьте наличие ошибок noindex page sitemap в Ahrefs Site Audit.

Ошибка 3. Оставлять директивы noindex на страницах, которые уже не находятся на стадии разработки

Закрывать от сканирования и индексации все, что находится на стадии разработки, — это нормальная, хорошая практика. Тем не менее, иногда продукт выходит на следующую стадию с директивами noindex или закрытым через robots.txt доступом к нему. Органического трафика в таком случае вы не дождетесь.

Более того, иногда падение органического трафика может протекать незамеченным на фоне миграции сайта через 301-редиректы. Если новые адреса страниц содержат директивы noindex, или в robots.txt прописано правило disallow, то вы будете получать органический трафик через старые URL, пока они будут в индексе. Их деиндексация поисковой системой может затянуться на несколько недель.

Чтобы предотвратить подобные ошибки в будущем, стоит добавить в чек-лист разработчиков пункт о необходимости удалять правила disallow в robots.txt и директивы noindex перед отправкой в продакшен.

Ошибка 4. Добавление «секретных» URL в robots.txt вместо запрета их индексации

Разработчики часто стараются спрятать страницы о грядущих промоакциях, скидках или запуске нового продукта через правило disallow в файле robots.txt. Работает это так себе, потому что кто угодно может открыть такой файл, и, как следствие, информация зачастую сливается в интернет.

Не запрещайте их в robots.txt, а закрывайте индексацию через метатеги или HTTP-заголовки.

Заключение

Правильное понимание и правильное управление сканированием и индексацией вашего сайта крайне важны для поисковой оптимизации. Техническое SEO может быть довольно запутанным и на первый взгляд сложным, но метатегов robots уж точно бояться не стоит. Надеемся, что теперь вы готовы применять их на практике!

4 случая использования noindex и nofollow · Блог PromoPult

Noindex и nofollow — похожие по форме, но разные по смыслу элементы. Их часто путают, и как их только не называют: тегами, метатегами, атрибутами. Сегодня мы расставим все точки над «i» и расскажем, чем отличается noindex от nofollow и в каких случаях их целесообразно использовать.

1. Метатеги

Прежде всего, noindex и nofollow (наряду с index и follow) — это указания для роботов в метатегах директивы <head>. Их понимают все без исключения поисковики. Указания index или noindex разрешают или запрещают роботу индексировать содержимое страницы, а follow и nofollow — переходить по ссылкам на странице.

Возможны такие варианты:

<meta name="robots" content="index, follow"/> — в этом случае разрешена индексация страницы и ссылок. <meta name="robots" content="noindex, follow"/> — запрещена индексация содержимого страницы, но разрешен переход по ссылкам. <meta name="robots" content="index, nofollow"/> — разрешена индексация, но запрещен переход по ссылкам. <meta name="robots" content="noindex, nofollow"/> — запрещается и индексация, и переход по ссылкам.

От индексации следует закрывать служебные страницы (админка, логи сервера) а также дублированный контент (страницы архивов, тегов, результаты поиска по сайту, пагинацию).

Если вы хотите оставить указания только для какого-то конкретного робота, то нужно просто указать его идентификатор в метатеге, например:

<meta name="googlebot" content="noindex, follow"/>

Если не задать указания для робота, то он по умолчанию принимает значения index и follow.

В SEO-модуле PromoPult на втором шаге создания проекта “Страницы” можно провести быстрый анализ страниц на предмет того, есть ли запреты на индексацию в метатегах. Проверка происходит за секунды и совершенно бесплатно.

2. Цитаты, копипаст и другой текст

Для того чтобы закрыть не всю страницу, а только ее часть от индексации, а именно служебные участки текста, используется тег <noindex>. Причем это «ноу-хау» Яндекса. Google тег не понимает и считает его невалидным. Синтаксис выглядит так:

<noindex>текст, который следует скрыть от индексации</noindex>

Проблема в том, что при такой конструкции во время валидации кода будут ошибки. Если вы хотите сделать код валидным, используйте такой синтаксис:

<!--noindex-->текст, который следует скрыть от индексации<!--/noindex-->

Скрывать от индексации есть смысл:

- дословные цитаты других авторов;

- выдержки из законодательства;

- регулярно повторяющийся одинаковый текст;

- служебный текст.

По поводу тега <noindex> есть заблуждение. Считается, что текст, помещенный в него, Яндекс вообще не учитывает. Это не так. Яндекс читает его и принимает во внимание при определении релевантности страницы и ее уникальности, просто он не добавляет его в индексную базу.

3. Ссылки

Изначально nofollow использовали только в метатеге на уровне страницы. Но со временем возникла острая необходимость закрывать не все ссылки на странице от индексации, а только некоторые из них. Так появился атрибут rel=»nofollow» тега . Он относится только к ссылке, для которой указан. Синтаксис выглядит так:

<a href="index.php" rel="nofollow">Перейти</a>

Некоторые пытаются закрывать ссылки от индексации таким образом:

<nofollow><a href="index.php">Перейти</a></nofollow>

Это неверно. Запомните, что тега <noindex> не существует — только атрибут rel или метатег со значением nofollow.

Более распространенная ошибка — попытка закрыть ссылку от индексации с помощью тега <noindex>. В этом случае будет закрыт только анкор, и только для Яндекса. По ссылке же роботы смогут переходить.

Закрывают ссылки атрибутом nofollow в таких случаях:

- Ненадежный контент (если вы не можете или не желаете поручиться за содержание страниц, на которые ведут ссылки, то лучше скрыть их от роботов. Например, атрибутом nofollow часто закрывают ссылки из комментариев в блогах или сообщений на форумах).

- Платные ссылки (если вы размещаете рекламные статьи, новости, обзоры, то закрытие ссылок атрибутом nofollow убережет вас от возможных санкций со стороны поисковых систем. Хотя, конечно, далеко не каждый рекламодатель захочет получать именно такую ссылку, поэтому этот подход практикуют лишь топовые площадки, и то не все).

- Приоритезация сканирования (роботам ни к чему переходить, например, по ссылкам на форму регистрации или личный кабинет. Использование атрибута nofollow позволит направить роботов в нужном русле и не тратить их время на бесполезное сканирование).

- Много внешних ссылок (если со страницы идет много внешних dofollow ссылок, то лучше закрыть некоторые из них. В противном случае страница будет терять вес).

- Перераспределение веса (с помощью nofollow можно перераспределить вес между внутренними страницами сайта. Но для этого нужно хорошо понимать, что именно и как делать, чтобы не получилось, что некоторые страницы будут просто выпадать из общей логики перелинковки).

4. Счетчики и блоки подписки

На страницах сайта зачастую расположено много служебных элементов, которые нет смысла индексировать. Их закрывают с помощью тега <noindex>. Прежде всего, это счетчики (Liveinternet, Яндекс.Метрика и т. п.), различные информеры, блоки оформления подписки и т. п. А вот блоки рекламы (Яндекс.Директ, Google Adsense и проч.) закрывать не нужно.

Совет напоследок

Некоторые оптимизаторы в погоне за сохранением драгоценного веса закрывают с помощью noindex и nofollow все, что только можно, не оставляя ни одной внешней ссылки. Это ошибка. Есть ли она на вашем сайте? Можно узнать, заказав аудит у “Персонального менеджера” PromoPult. Дело в том, что ссылки на авторитетные ресурсы поднимают рейтинг вашего сайта в глазах поисковиков. Не бойтесь ссылаться — это вполне нормально, если вы указываете источники данных и полезные ресурсы.

Описание мета-тегов в head страницы html

Посмотрев HTML код разных сайтов возникает вопрос – зачем в нем так много мета-тегов и для чего они нужны? В данной статье представлены все самые встречающеюся теги с примерами и пояснениями.

1

Описание страницы

Title

Заголовок страницы, оптимальная длина 50-60 символов.

Description

Краткое описание страницы длинной 160-180 символов, используется в выводе результатов поиска.

<meta name="description" content="...">Keywords

Содержит ключевые слова встречающихся на странице. Не более 20-ти слов и 3-х повторов.

<meta name="keywords" content="...">- Google – не использует.

- Яндекс – под вопросом.

Кодировка сайта

<meta http-equiv="content-type" content="text/html; charset=utf-8">В HTML5 тег сократили:

Application-Name

Название веб-приложения. Можно указать несколько названий для разных языковых локалей.

<meta name="application-name" content="Моё приложение">

<meta name="application-name" lang="en" content="My application">

<meta name="application-name" lang="fr" content="Mon application">- В Android используется при добавлении сайта на главный экран.

- В Windows 8, 10 при добавлении сайта в панель приложений и плиткой в меню пуск.

Generator

Сообщает, с помощью какой программы был сгенерирован код страницы.

<meta name="generator" content="...">Author

Информация об авторе сайта.

<meta name="author" content="...">Copyright

Информация о владельце сайта.

<meta name="copyright" content="...">Reply-To

Указывает способ связи с автором страницы.

<meta name="reply-to" content="[email protected]">Content-Language

Указывает язык страницы. Используется поисковыми машинами при индексировании.

<meta http-equiv="content-language" content="ru">Help

Предоставляет ссылку на справку или e-mail.

<link rel="help" href="mailto:[email protected]">2

Управление индексацией

Robots

Задает правила индексации для поисковых

<meta name="robots" content="index, follow">Общие значения:

index, follow или all |

Разрешено индексировать текст и ссылки на странице |

noindex |

Не индексировать текст страницы |

nofollow |

Не переходить по ссылкам на странице |

noindex, nofollow или none |

Запрещено индексировать текст и переходить по ссылкам |

noarchive |

Не показывать ссылку на сохраненную копию в поисковой выдаче |

Яндекс

noyaca |

Не использовать описание из Яндекс.Каталога для сниппета в результатах поиска |

nosnippet |

Запрещает показывать видео или фрагмент текста в результатах поиска |

noimageindex |

Запрещает указывать вашу страницу как источник ссылки для изображения |

noodp |

Не использовать описание из каталога DMOZ |

Last-Modified

Альтернативно HTTP-заголовку Last-Modified задает дату последнего изменения для статических страниц.

<meta http-equiv="last-modified" content="2017-12-31@08:04:23 +00:00">Document-State

Определяет частоту индексации для поисковых роботов.

<meta name="document-state" content="dynamic">static |

Индексировать один раз |

dynamic |

Индексировать страницу регулярно |

Revisit-After

Указывает как часто обновляется информация на сайте, и как часто поисковая система должна на него заходить.

<meta name="revisit-after" content="5 days">3

Управление кэшированием

Cache-Control

Указывает как браузеру кэшировать страницу.

<meta http-equiv="cache-control" content="no-cache">public |

Кэшируется все |

private |

Кэшируется браузером, но не proxy-сервером |

no-cache |

Запрещает кэширование |

max-age=0 |

Сколько секунд хранить в кэше |

Pragma

Отключает кэширование.

<meta http-equiv="pragma" content="no-cache">Expires

Дата окончания кэша браузера. Если указать прошедшую дату или 0, то документ не будет кэшироваться.

<meta http-equiv="expires" content="0">4

Canonical — предпочитаемый канонический адрес

Если у страницы есть дубликаты с одним содержанием и разными URL, например:

http://exaple.comcategory/jqueryhttp://exaple.com/category/jquery?sort=desc

В rel="canonical" указывается адрес, который будет считаться основным и будет использоваться в поисковой выдаче.

<link rel="canonical" href="http://exaple.com/jquery">Prev

Указывает URL предыдущий страницы при пагинации.

<link rel="prev" href="http://example.com/jquery">Next

Указывает URL следующий страницы при пагинации.

<link rel="next" href="http://example.com/jquery?page=3">5

Rel Alternate

Атрибут «Hreflang»

Этот атрибут указывает ссылки на разные языковые версии сайта. Код языка указывается в формате ISO 639-1.

<link rel="alternate" hreflang="ru" href="http://ru.example.com/">Или код языка и региона, регион указывается в формате ISO 3166-1 Alpha 2:

<link rel="alternate" hreflang="ru-RU" href="http://ru-ru.example.com/">Значение x-default говорит о том что страница главная и не соответствует какому-либо языку или региону.

<link rel="alternate" hreflang="x-default" href="http://example.com/">Описание: Яндекс Google

Атрибут «Media»

Значение handheld или only screen and (max-width: 640px) указывают адрес мобильной версии.

<link rel="alternate" media="handheld" href="http://m.example.com/">

<link rel="alternate" media="only screen and (max-width: 640px)" href="http://m.example.com/">Атрибут «Type»

application/rss+xml – ссылка на RSS канал.

<link rel="alternate" type="application/rss+xml" href="http://example.com/rss">application/atom+xml – фид в формате Atom.<link rel="alternate" type="application/atom+xml" href="http://example.com/atom">6

Google-Site-Verification

Подтверждение прав пользователя сервисов Google.

<meta name="google-site-verification" content="...">Google-Play-App

Подобно apple-itunes-app выводит баннер приложения в Андроид.

<meta name="google-play-app" content="app-id=ru.название_приложения">Значение «Notranslate»

Если страница написана на языке, который не подходит пользователю, Google добавляет ссылку, позволяющую сделать перевод на нужный язык. Значение notranslate отключает эту функцию.

<meta name="google" value="notranslate">Значение «Nositelinkssearchbox»

Иногда в результатах поиска Google рядом со ссылками на сайт появляется окно поиска по сайту. С помощью данного мета-тега можно отключить показ этого поля.

<meta name="google" content="nositelinkssearchbox"> Chrome-Webstore-Item

Добавление ссылки в Интернет-магазин Chrome.

<link rel="chrome-webstore-item" href="https://chrome.google.com/webstore/detail/xxxxxxxxxxxxx">Publisher

Google использует для связи между сайтом и его страницей в Google+.

<link rel="publisher" href="https://plus.google.com/xxxxxxxxx">7

Разное

Search

Указывает на XML файл OpenSearch, который позволяет делать поиск по сайту в браузере не заходя на него.

Подробнее о формате на http://opensearch.org.

<link rel="search" type="application/opensearchdescription+xml" title="Поиск на example.com" href="http://example.com/opensearch.xml">Referrer

Задает HTTP-заголовок «Referer» который отправится на сервер при переходе по ссылкам.

<meta name="referrer" content="origin">none |

Никогда не передает заголовок |

none-when-downgrade |

Заголовок передается только если используется HTTPS |

origin |

Передает данные о хостах и поддоменах |

unsafe-url |

Передает полный URL |

Refresh

Задаст задержку в секундах, после чего браузер обновит страницу.

<meta http-equiv="refresh" content="10">Также можно указать другой адрес по которому перейдет браузер после задержки.

<meta http-equiv="refresh" content="10; URL=http://www.name.com/">Skype Toolbar

Мета-тег skype_toolbar отключает расширение Skype на странице (только старые версии).

<meta name="skype_toolbar" content="skype_toolbar_parser_compatible"> CSRF

Свидетельствует о том, что на сайте реализована защита от CSRF-атак.

<meta name="csrf-token" content="gZoOqHdVwfq2QpfkwH6lQE75ivykrHdOS0rVfhiX">

<meta name="csrf-param" content="authenticity_token">Ссылка на канал в телеграм

<meta name="telegram:channel" content="@telegram">Тег Base

Указывает браузеру как обрабатывать относительные URL в ссылках и src изображений относительно адреса текущей страницы.

В примере, браузер запросит изображение по адресу:http://site.ru/category/images/logo.png

<head>

<base href="http://example.com/category/">

</head>

<body>

<img src="images/logo.png">

</body>▲Как закрыть дубли страниц от индексации. Использование noindex, nofollow и rel canonical

На финальных этапах разработки сайта необходимо обратить максимум внимания техническим аспектам оптимизации сайта. Задачей №1 для SEO специалиста является правильная и полная индексация сайта.

На финальных этапах разработки сайта необходимо обратить максимум внимания техническим аспектам оптимизации сайта. Задачей №1 для SEO специалиста является правильная и полная индексация сайта.

Индексация сайта

Индексация сайта – это автоматический процесс сбора информации о содержании сайта, который выполняют поисковые роботы. После чего данные страниц сайта попадают в поисковую выдачу.

Для того, что бы все страницы сайта успешно попали в поисковую выдачу мы должны проследить за тем, что бы все контентные страницы были доступны для поисковых роботов. Дать рекомендации поисковому роботу можно при помощи таких инструментов как robots.txt, а так же sitemap. Кроме проблемы доступности нужных страниц в поиске, есть еще и проблема скрытия от поисковых роботов ненужных данных (страницы пагинации, фильтров, и другие дубли). Нужно запомнить, что и robots.txt и sitemap носят преимущественно рекомендательный характер и могут привести к индексации нежелаемых данных. Что же делать что бы правильно закрыть дубли страниц от индексации?

Закрываем дубли при помощи команды Noindex, nofollow

То что гарантированно обеспечит отсутствие дублей в поисковой выдаче – это тег:

<meta name="robots" content="noindex, nofollow">,

поисковый робот не при каких обстоятельствах не внесет в индекс информацию со страницы с таким тегом. Не имеет значения разрабатывает вам сайт веб студия или вы

используете готовое решение интернет-магазина, в любом случае дополнительная внимательность не помешает. Страницы на которых нужно использовать тег noindex, nofollow

Noindex, follow для страниц пагинации

В некоторых случаях желательно использовать вот такую комбинацию

<meta name="robots" content="noindex, nofollow">.

Данная комбинация очень хорошо подходит для страниц пагинации. Дело в том, что поисковому роботу очень удобно индексировать новые статьи или товары проходясь по страницам пагинации, но в плане контента данные страницы бесполезны. Поэтому мы даем роботу команду что чтение данных страниц возможно, но добавление их в индекс запрещено.

Rel canonical

Еще один тег, который создан специально для улучшения индексации вашего сайта это тег rel canonical. В коде страницы он имеет такой вид: <link href="ссылка основной страницы" rel="canonical" />. Этот тег так же можно использовать для решения проблем страниц пагинации. Для того, что бы поисковая система не индексировала множество дублей, достаточно на все страницы пагинации добавить такой код, а вместо слов “ссылка основной страницы” указать например первую страницу пагинации (которая должна быть в индексе). На некоторых сайтах оптимизаторы используют данный тег на всех страницах, указывая в поле для канонической ссылки ссылки (основная страница) ссыклу самой страницы. Это так же помогает поисковой системе отсеять дубли, которые могли появиться при переходе по непрямой ссылке.

Оцени пост!

Loading…

Loading…Статьи по теме

HTML МЕТА-тег РОБОТЫ

У Вас в браузере заблокирован JavaScript. Разрешите JavaScript для работы сайта!

МЕТА тег роботы для того, чтобы разрешать или запрещать роботам, приходящим на сайт, индексировать систему страницу. Кроме того, этот тег предназначен для того, чтобы предлагать роботам пройтись по всем страницам сайта и проиндексировать их. Кроме того, этим тегом могут воспользоваться те, кто не имеет доступа к корневому каталогу сервера и изменить файл robots.txt, но хочет запретить к индексирование своих файлов и директории.

Формат мета-тега Роботы

МЕТА тег роботы помещается в тег html-документа (внутри тега

). Формат достаточно прост (регистр букв значения не играет) Данному мета-тегу можно присвоить четыре варианта значений. Атрибут CONTENT может содержать следующие значения:

Index (индексировать), noindex (не индексировать), follow (следовать по ссылкам), nofollow (не следовать по ссылкам)

, не индексировать данный документ:

Для одновременного запрета индексирования страницы и обхода ссылок с нее використов

Если значений несколько, то они разделяются запятыми.

Чтобы запретить индексирование страницы на вашем сайте только роботам Google и разрешить ее индексирование другим роботам, используйте следующий тег:

Чтобы разрешить роботам индексировать страницу, но запретить индексирование картинок на странице, используйте следующий тег:

Google создает и архивирует «снимок» каждой сканируемой страницы.Версия, сохраненная в кэше, позволяет показывать вашу страницу конечным пользователям, даже если исходная страница недоступна (из-за временной технической проблемы на веб-сервере). Сохраненная в кэше странице представляется пользователи в том виде, в котором ее в последний раз просканировал робот Google, при этом вверху страницы мы показываем сообщение о том, что это версия из кэша. Пользователи могут получить доступ кэшированной версии, созданной на ссылку «Сохранено в кэше», созданную на странице результатов поиска.

Чтобы запретить всем поисковым системам вывести эту ссылку на ваш сайт, добавить в раздел

следующий тег:Чтобы запретить выводить посылку «Сохранено в кэше» только в системе Google, а остальным разрешить, используйте следующий тег:

Примечание. Этот тег удаляет только ссылку «Сохранено в кэше» на соответствующую страницу. Google продолжит индексировать страницу и выводить ее фрагмент.

Предотвращение сканирование или удаление фрагментов

Фрагмент — это текст, который показывается под страницей списка результатов и приведенного содержания.

Чтобы запретить Google выделить фрагменты с вашей страницы, добавить в раздел

следующий тег:Примечание. При удалении фрагментов удаляются также и сохраненные в кэше страницы.

Как сделать так, чтобы поисковые системы не использовали данные DMOZ в результатах поиска для вашего сайта

Одним из источников, которые используются при создании фрагментов описаний, является Open Directory Project.Чтобы никакие поисковые системы (поддерживающие метатеги) не использовали эту информацию для описания, добавьте следующий тег:

Чтобы только для Google запретить использовать эту информацию в описании страницы, добавить тег:

Если метатег «robots» используется для других команд, их можно объединить. Пример:

Пример использования описания:

Поисковые запреты

Как сказать поисковой машине, что определенный участок кода не нужно индесировать или что по данной ссылке не нужно следовать?

Каждый поисковик тут изобретает свой велосипед: Яндекс рекомендует заключать подобный текст в теги

Тег NOINDEX

Запретить индексирование можно не только для файлов, но также и для их частей.Для того, чтобы запретить индексирование отдельных частей файлов (текстовых), необходимо пометить их специальными тегами.При этом, тег NOINDEX не должен нарушать вложенность других тегов. Понимает только ПС Яндекс.

rel = «nofollow»

Чтобы указать поисковой системе не идти по ссылке, в теге A можно указать атрибут rel = «nofollow» :

rel="nofollow" href="htmlweb.ru> WEB-технологииДанный атрибут не влияет на индексцию.В большинстве поисковиков (кроме Google) переход по ней все-таки осуществляется. Единственная задача данной атрибута — сообщить поисковой системе, что рейтинг со страницы, на которой ссылка размещена, не должен передаваться, на которую должна идти ссылка.

Если вам необходимо уменьшить количество внешние ссылки на странице, заключите их в теги или здесь ссылки

Использованны материалы с поисковых систем:

Google

class = «robots-nocontent»

Применение «class = robots-nocontent» Атрибут:Ниже приводятся несколько примеров того, как использовать этот атрибут для различных целей и различных вариантов синтаксиса:

Это навигационное меню сайта и является общим на всех страницах.Она содержит много терминов и слов, не связанных с сайтом

Это сайт заголовок, присутствует на всех страницах сайта

и не связан с какой-либо конкретной страницей

Это Юридическая информация требуется на каждую страницу сайта

Как часто индексировать документ поисковому роботу?

Вебмастер может «сказать» поисковому роботу или файлу закладка пользователя, что содержимое того или иного файла будет изменяться.В этом случае робот пользователя внесет или не внесет файл в закладку. Пока эта информация описывается только в файле /robots.txt, Пользователь не будет знать о том, что эта страница будет изменяться.

Мета-таг ДОКУМЕНТ-ГОСУДАРСТВО может быть полезен для этого. По умолчанию, этот мета-таг принимается с CONTENT = STATIC.

Зеркала

Как исключить индексирование поисковой системой генерируемых страниц или дублирование документов, если есть зеркала сервера?

Генерируемые страницы — страницы, порождаемые CGI-скриптов.Их наверняка не следует индексировать, поскольку если попробовать провалиться в них из поисковой системы, будет выдана ошибка. Что касается зеркал, то негоже, когда выдаются две ссылки на разные сервера, но с одним и тем же содержимым. Чтобы этого избежать, следует использовать мета-таг URL с указанием абсолютного URL этого документа (в случае зеркал — на соответствующую страницу главного сервера).

Ещё почитать по теме:

.Директивы Meta Robots и как их использовать

Meta Robots — это метатег, который позволяет настроить инструкции по индексу сайта. Его плюсы заключаются в надёжности и простоте установки. Но многие вебмастера и специалисты по SEO часто ограничиваются лишь директивами noindex и nofollow , указывающими на индексирование страниц сайта и обязся на них ссылок.

Я решил подробнее использовать возможности Meta Robots, используя другие способы использования Meta Robots, которые вы сможете применить для SEO-продвижения вашего сайта.

Директивы Meta Robots и какие поисковые системы их учитывают

Всего существует чуть больше десятка основных директив Meta Robots, которые можно комбинировать между собой:

-

noindex— запрещает индексирование страницы. -

nofollow— запрещает роботу переходить по ссылкам с этой страницы. -

нет— аналогичные комбинации noindex, nofollow. -

всего— нет ограничений на индексирование и показ контента.Директива используется по умолчанию и влияет на работу поисковых роботов, если нет других указаний. -

noimageindex— не индексировать изображения на этой странице. -

noarchive— запрещает показывать ссылку «Сохраненная копия» для стандартной страницы. -

nocache— указывает на необходимость отправить запрос на сервер для валидации ресурса перед использованием кэшированных данных. -

nosnippet— запрещает показывать видео или фрагмент текста в результатах поиска. -

notranslate— запрещает предлагать перевод этой страницы в результатах поиска. -

unavailable_after: [RFC-850 дата / время]— указывает на то время и время, когда нужно прекратить сканирование и индексирование этой страницы. -

noodp— не использовать метаданные из проекта Open Directory для заголовков или фрагментов этой страницы. -

noydir— не брать название сайта и его описание из Yahoo! Каталог (каталог Yahoo!). -

noyaca— не использовать описание из Яндекс.Каталога для сниппета в результатах поиска.

Некоторые из директив по-разному воспринимаются роботами тех или поисковых систем. В таблице ниже собрана информация о том, как боты систем Google, Yahoo, Bing и Яндекс работают с директивами Meta Robots.

| Директивы | Yahoo | Bing | Яндекс | |

|---|---|---|---|---|

| индекс | Да * | Да * | Да * | Да |

| noindex | Да | Да | Да | Да |

| следовать | Да * | Да * | Да * | Да |

| nofollow | Да | Да | Да | Да |

| нет | Да | ? | ? | Да |

| все | Да | ? | ? | Да |

| noimageindex | Да | Нет | Нет | Нет |

| без архива | Да | Да | Да | Да |

| нокаш | Нет | Нет | Да | Нет |

| носниппет | Да | Нет | Да | Нет |

| нотранслит | Да | Нет | Нет | Нет |

| недоступен_после | Да | Нет | Нет | Нет |

| лапша | Нет | Да ** | Да ** | Нет |

| нойдир | Нет | Да ** | Нет | Нет |

| Нояка | Нет | Нет | Нет | Да |

* Поисковая система не имеет официальной документации, которая бы подтверждала поддержку этой директивы.Но соглашает что поддержка исключающего значения (например, nofollow) подразумевает поддержку положительного (например, подписаться).

** Теги noodp и noydir перестали поддерживаться, и, вероятно, не работают.

ДирективыMeta Robots, которые стоит использовать в SEO

Как мы видим из предыдущей таблицы, не все атрибуты метатега Роботы поддерживаются поисковой системой Google, которые оптимизируют сайты большинства разработчиков и SEO-специалистов. Поэтому рассмотрим те атрибуты метатега Роботы, которые поддерживаются Google:

- носниппет,

- noimageindex,

- без архива,

- unavailable_after.

Все они прописываются в блоке , к которой вы хотите применить те или иные инструкции по индексации.

Носниппет

Эта директива может пройти, если, например, вы хотите предотвратить попадание вашего сайта в блоки с готовыми ответами Google (Featured Snippet). Несмотря на то, что фрагмент контента в Featured Snippet, как правило, позволяет повысить конверсию, всё же он может отвлекать внимание от самого сайта.То есть, у пользователей, получивших ответ на свой вопрос, пропадает надобность кликать по ссылке.

Для решения проблемы вам следует использовать инструкцию следующего вида:

. Также важно учитывать атрибуты откликаются и отображаются расширенных сниппетов в результатах поиска.

К тому же исследование HubSpot, что сниппеты с расширенной информацией получают в два раза больше кликов.Соответственно, отключение сниппета может стать причиной снижения CTR вашего сайта или отдельных его страниц.

Noimageindex

Директива noimageindex позволит скрыть графический контент на вашем сайте из результатов поиска по картинке. Это может быть полезно, если вы, к примеру, хотите link на своём блоге уникальные изображения при этом минимизировать риск воровства.

запретить поисковым системам индексировать изображения, задайте в блоке html-документа следующую директиву:

Действие необходимо повторить с каждой страницы, которое содержит изображения, которые вы хотите скрыть от поисковиков.Учитывайте, что если другие сайты уже ссылаются на ваши изображения, поисковики могут индексировать их.

Запрещая загрузку изображений, не забывайте о том, что поиск по картинкам может принести хороший дополнительный трафик вашему сайту.

Noarchive

Директива может пригодиться тем, кто работает с интернет-магазинами. К примеру, на вашем сайте есть с товарами и на них стоимость страницы. Так как цены с установленной периодичностью меняются, кэшированные страницы товаров могут быстро терять свою актуальность.Для предотвращения кэширования поместите в такую страницу строки:

Вопреки распространённому мнению, директива noarchive никак не влияет на ранжирование — эту информацию подтвердил в своем Твиттере аналитик компании Google, специалист отдела качества поиска по работе с вебмастерами Джон Мюллер (Джон Мюллер).

Директива недоступна_ после наиболее актуальна для страниц с акционными предложениями.Так как по истечению времени действия акции они теряют свою актуальность, вы можете указать поисковикам крайнего срока содержания контента. Дату и время указывать в формате RFC 850.

К примеру, если вам нужно исключить индексции страницы после 25 марта 2019 года, используйте метатег следующего вида:

Отдельно отметим, что для правильного функционирования тега необходимо, чтобы он был прописан до первого обхода роботом.В таком случае запрос на удаление из поисковой выдачи займёт примерно сутки после наступления даты.

Проверка правильности Meta Robots и его содержимое в Netpeak Spider

Перед проверкой атрибутов Meta Robots, какие страницы индексируются на сайте, иначе не будет смысла внедрять вышеописанные атрибуты.

Программа для операционных систем Microsoft Windows и Mac OS, поддержка платформы Linux в данный момент не доступна, но находится в.Вы можете воспользоваться бесплатной версией в течение 14 дней без каких либо ограничений.

Воспользуйтесь возможностью промокодом c6c39672 при оформлении заказа и получите специальную скидку 10% на покупку Netpeak Spider и Netpeak Checker!

С помощью Netpeak Spider вы можете найти запрещенные индексции страницы. На таких программах делает особый акцент страниц, отмечая ошибками:

- Заблокировано в Meta Robots. Показывает страницы, запрещенные к индексции с помощью инструкции

- Nofollow в Meta Robots. Показывает страницы, инструкции

Для проверки сайта откройте программу и откройте вкладку «Параметры» на боковой панели. Найдите «Индексация» и проверьте раздел, отмечен ли галочкой пункт «Meta Robots». Пункт не проанализирует метатег, и вы в финальном отчете показывает данные о нём.

Для сканирования всего сайта введите его начальный URL в адресную строку и нажмите кнопку «Старт».Если вам необходимо просканировать список страниц, зайдите в меню «Список URL» и выберите удобный вам способ добавления URL (выполнить вручную, загрузить из файла или карту сайта, вставить из буфера обмена), после чего запустите сканирование.

По завершению сканирования получить информацию о Meta Robots.

1. В основной таблице на вкладке «Все результаты». В столбце Meta Robots просмотрите директивы, которые содержат соответствующие теге каждой из просканированных страниц.

2. На вкладке «Ошибки» боковой панели. Найдите ошибки, связанные с Meta Robots, и кликните по их названию. В таблице отфильтрованных результатов вы увидите полный список страниц, на которых были найдены эти ошибки.

3. На вкладке «Дашборд». Вы можете просмотреть данные в виде диаграммы об индексируемых страницах на сайте, а также узнать причины их неиндексируемости. Кликните на интересующую вас область, чтобы получить список страниц, соответствующим или иному значению.

4. На вкладке «Сводка» на боковой панели. Здесь вы можете ознакомиться как закрытые от индексации страницы, так и посмотреть, какие ещё значения include noindex, nofollow заданы в метатеге Robots. Найдите пункт «Meta Robots» со списком всех покупателей на сайте директив. Кликните на любую из них, чтобы ознакомиться со страницами, на которых они были найдены.

При необходимости выгрузить функцию «Экспорт», чтобы выгрузить отфильтрованные результаты в отдельный файл формата .xlsx на свой компьютер. Нажмите на кнопку «Экспорт» в левом верхнем углу результатов или выберите в соответствующем меню команду «Результаты в текущей таблице».

Коротко о главном

Meta Robots — удобный инструмент, который позволяет управлять индексами сайта и его отдельных страниц. Однако зачастую его использование ограничивает атрибутами индекса индексации — noindex, nofollow.

На деле же он может быть как минимум 4 директивами, которые представляют собой воспринимаемые поисковыми роботами Google и выполняют разного рода SEO-задачи.В их числе — nosnippet, noimageindex, noarchive и unavailable_after.

Проверить директивы метатега Роботы всего сайта или списка установленных URL удобнее всего с помощью Netpeak Spider. Программа покажет все возможные ошибки, связанные с метатегами, и предоставит данные об атрибутах в максимально наглядном виде.

Краулер программы глубокий анализ сайта в автоматическом режиме получает его измененную и находит ошибки полной технической оптимизации.Умеет находить битые ссылки и редиректы, обнаруживать дублирование страниц, Заголовок, Описание, заголовки h2 и т.д — проверяет более 50 ключевых параметров. Настоятельно рекомендую!

.Полное руководство по Robots.txt и метатегу Noindex

Файл Robots.txt и мета-тег Noindex важны для SEO-продвижения. Они информируют Google, какие именно страницы необходимо сканировать, а какие — индексировать (отображать в результатах поиска).

С помощью этих средств можно ограничить содержимое сайта, доступное для индексции.

Robots.txt — это файл, который указывает поисковым роботам (например, Googlebot и Bingbot), какие страницы сайта не должны сканироваться.

Файл robots.txt сообщает роботам системам, какие страницы могут быть просканированы. Но не может контролировать их поведение и скорость сканирования сайта. Этот файл, по сути, представляет собой набор инструкций для поиска роботов о том, к каким частям сайта доступ ограничен.

Но не все поисковые системы работают директивы файла robots.txt. Если у вас остались вопросы насчет robots.txt, ознакомьтесь с часто задаваемыми вопросами о роботах.

По умолчанию файл robots.txt выглядит следующим образом:

Можно создать свой собственный файл robots.txt в любом редакторе, который поддерживает формат .txt. С его помощью можно заблокировать второстепенные веб-страницы сайта. Файл robots.txt — это способ сэкономить лимиты, которые могут пойти на сканирование других разделов сайта.

User-Agent: укажите поискового робота, для которого будут ограничения ограничения в сканировании URL-адресов. Например, Googlebot, Bingbot, Ask, Yahoo.

Disallow: определяет адреса страниц, которые запрещены для сканирования.

Разрешить: только Googlebot придерживается этой директивы. Она разрешает анализировать страницу, несмотря на то, что сканирование родительской веб-страницы запрещено.

Карта сайта: указывает путь к файлу карта сайта сайта.

В файле robots.txt символ (*) используется для обозначения любой символы.

0002 Директива для всех типов роботов:Пользовательский агент: *

Также символ * можно использовать, чтобы запретить все URL-адреса кроме родительской страницы.

User-agent: *

Disallow: / developers / *

Disallow: / Categories / *

Это означает, что все URL-адреса дочерних страниц авторов и страниц категорий заблокированы за исключением главных страниц этих разделов.

Ниже приведен пример правильного файла robots.txt:

User-agent: * Запретить: / testing-page / Запретить: / account / Disallow: / checkout / Запрещено: / cart / Запрещено: / products / page / * Запретить: / wp / wp-admin / Разрешить: / wp / wp-admin / admin-ajax.php Карта сайта: yourdomainhere.com/sitemap.xml

После того, как отредактируйте файл robots.txt, разместите его в основной директории сайта. Этот поисковый робот увидит файл robots.txt сразу после захода на сайт.

Noindex — это метатег, который запрещает поисковым системным индексом страницу.

Существует три способа добавления Noindex на страницы:

Разместите приведенный ниже код в разделе

страницы:Он сообщает всем типам поисковых роботов об условиях страницы .Если нужно запретить индексцию страницы только для определенного робота, поместите его название в значение атрибута name.

Чтобы запретить индексцию страницы для робота Googlebot:

Чтобы запретить индексцию страницы для Bingbot:

Также можно разрешить или запретить роботам переход по ссылкам, размещенным на странице.

Чтобы разрешить переход по ссылкам на странице:

Чтобы запретить поисковым роботам сканировать ссылки на странице:

x-robots-tag позволяет управлять индексцией страницы через HTTP-заголовок.Этот тег также указывает поиск системам не отображать тип файлов в результатах поиска. Например, изображения и другие медиа-файлы.

Для этого у вас должен быть доступ к файлу .htaccess. Директивы в метатеге «роботы» также применимы к x-robots-tag.

Плагин YoastSEO в WordPress автоматически генерирует приведенный выше код. Для этой страницы ввода ввода в интерфейс YoastSEO в настройке публикации, щелкнув по значку шестеренки. Затем в опции «Разрешить поисковыми системам показывать эту публикацию в результатах поиска?» выбрать «Нет».

Также можно задать тег noindex для страниц категорий. Для этого зайдите в плагин Yoast, в «Вид поиска». Если в разделе «Показать категории в результатах поиска» выбрать «Нет», тег noindex будет размещен на всех страницах категорий.

- Чтобы проиндексированная страница удалена из результатов поиска, убедитесь, что она не заблокирована в файле robots.txt. И только потом добавляйте тег noindex. Иначе робот Googlebot не сможет увидеть тег на странице. Если заблокировать страницу без тега noindex, она все равно будет в результатах поиска:

- Добавление директивы карты сайта в файл robots.txt технически не требуется, но считается хорошей практикой.

- После обновления файла robots.txt рекомендуется проверить, не заблокированы ли важные страницы. Это можно сделать с помощью txt Tester в Google Search Console.

- используйте инструмент проверки URL-адреса в Google Search Console, чтобы увидеть статус индексации страницы.

- Также можно проверить, проиндексировал ли Google ненужные страницы. Это можно сделать с помощью отчета в Google Search Console. Еще одной альтернативой может быть использование оператора «site».Это команда Google, которая отображает все страницы сайта, доступные результаты поиска.

В последнее время в SEO-сообществе было много недоразумений по поводу использования noindex в robots.txt. Но представители Google много раз говорили, что поисковая система не данный метатег. И все же многие люди настаивают на том, что он все еще работает. Но лучше избегать его использования.

Заблокированные через robots.txt страницы, не могут быть проиндексированы, даже если кто-то на них упомянут.

Чтобы страница без контента случайно не появилась в результатах, Джон Мюллер рекомендует размещать на этих веб-страницах noindex даже после того, как вы заблокировали их в robots.txt.

Использование файла robots.txt улучшает не только SEO, но и пользовательский опыт. Для этого реализуйте приведенные выше практики.

Данная публикация представляет собой перевод статьи «Полное руководство по Robots.txt и Noindex Meta Tag», подготовленной дружной командой проекта Интернет-технологии.ру

телеграм канал. Подпишись, будет полезно!

.Руководство по метатегам Роботы и X-robots-tag

Перед вами дополненный (конечно же, выполненный с любовью) перевод статьи Robots Meta Tag и X-Robots-Tag: все, что вам нужно знать c блога Ahrefs. Дополненный, потому что в оригинальном материале «Яндекс» включается лишь вскользь, в главе про HTTP-заголовки просматривается только сервер Apache. Мы дополнили текст информацией по метатегам «Яндекса», а в части про X-Robots-Tag привели примеры для сервера Nginx.Так что этот перевод актуален для самых популярных поисковых систем и веб-серверов. Круто, правда?

Приятного чтения!

Направить поисковые системы таким образом, чтобы они сканировали и индексировали ваш сайт именно так, как вы хотите, порой может быть непросто. Хоть robots.txt и управляет доступностью вашего контента для ботовых систем, он не указывает краулерам на то, стоит индексировать страницы или нет.

Для этой цели существуют метатеги robots и HTTP-заголовок X-Robots-Tag .

Давайте проясним одну вещь с самого начала: вы не можете выполнить индекс через robots.txt. Распространенное заблуждение — считать.

Правило noindex в robots.txt официально никогда не поддерживалось Google. 2 июля 2019 года Google опубликовал новость, в которой описаны новые и неподдерживаемые директивы файла robots.txt. С 1 сентября 2019 года такие правила, как noindex в robots.txt, официально не поддерживаются.

Из этого руководства вы узнаете:

- что такое метатег роботов ;

- почему роботы важен для поисковой оптимизации;

- каковы значения и атрибуты метатега роботы ;

- как внедрить роботов ;

- что такое X-Robots-Tag ;

- как внедрить X-Robots-Tag ;